NVIDIA近期隨CUDA 13.1版本更新提出的CUDA Tile架構,表面上是程式開發模型的更新,但若深入觀察其市場策略,這無疑是NVIDIA繼硬體算力市場擴大佈局,日前更宣布入股電子設計自動化業者Synopsys後,更進一步針對軟體生態系祭出的最重磅防禦——藉由抽象化層讓GPU在執行AI運算時,能「偽裝」成一顆TPU (張量處理單元),試圖在程式開發的易用性上,徹底抹平競爭對手ASIC (特殊應用積體電路) 的優勢。

策略一:吸收ASIC優勢,讓GPU具備「雙重人格」

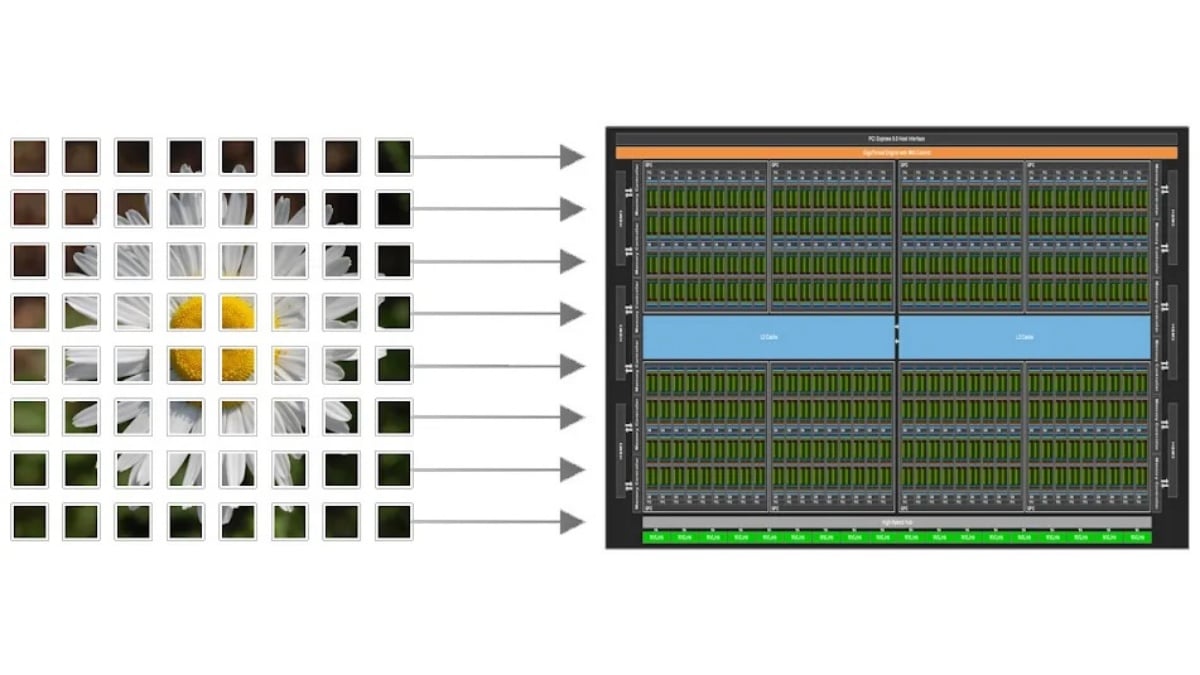

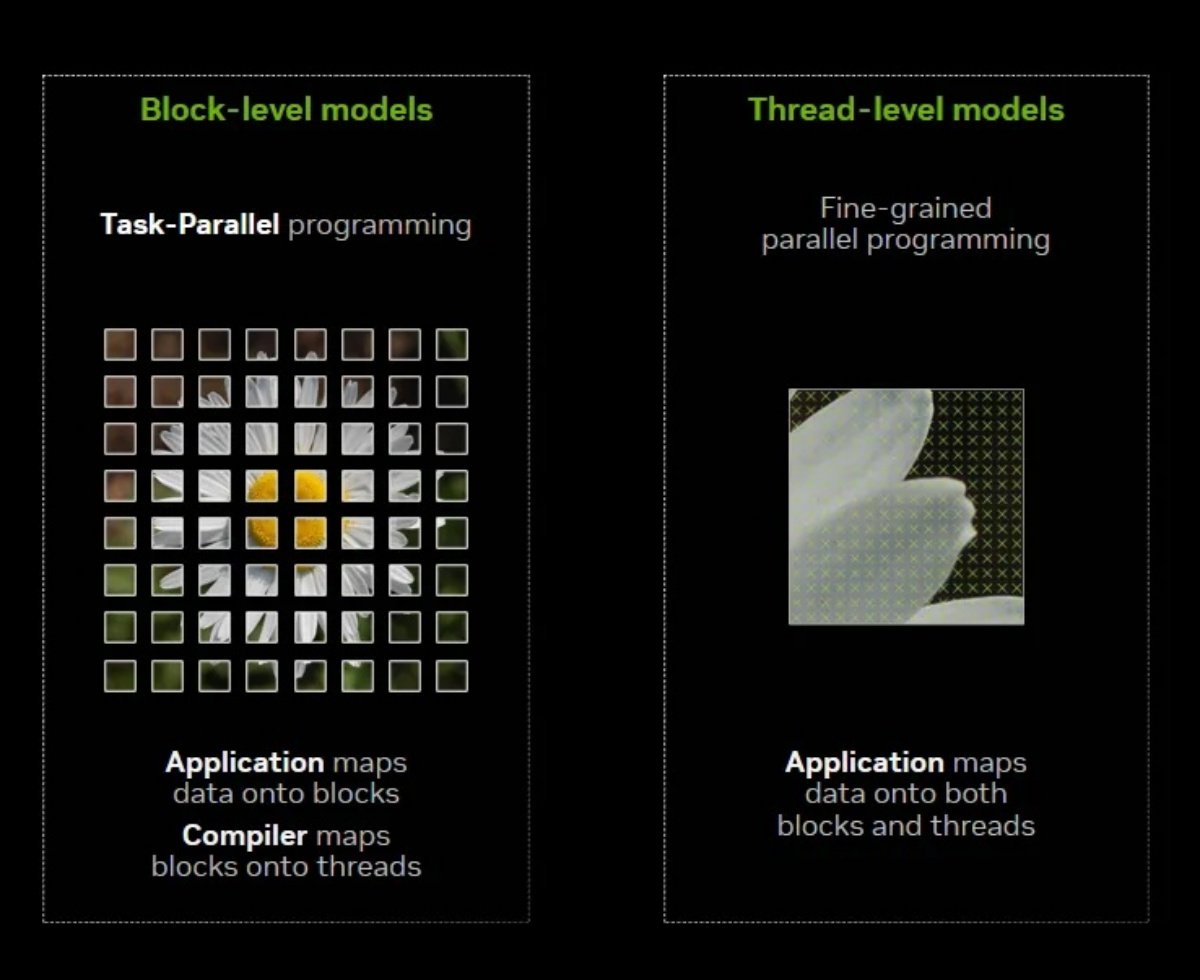

過去,GPU的強項在於SIMT (單指令多執行緒) 架構,適合處理圖形渲染或高彈性的平行運算,這也是CUDA稱霸多年的基礎。但隨著AI模型 (特別是Transformer架構)對矩陣乘法與張量運算的需求暴增,Google TPU或AWS Trainium這類專為「矩陣磚塊」 (Tile)運算設計的ASIC,因其架構更貼近AI演算法邏輯,在能效與特定開發場景上對NVIDIA構成威脅。

但目前NVIDIA的策略顯然並非放棄SIMT架構,而是透過CUDA Tile架構讓GPU能具備「雙重人格」。

• 保有通用性:需要彈性時,它仍是那顆無所不能的GPU。

• 模擬專用性:當處理AI張量時,透過CUDA Tile IR (虛擬指令集),它能像TPU一樣以「磚塊」為單位進行資料搬移與運算,無需開發者手動管理執行緒。

這意味NVIDIA直接在軟體層面「吃掉」ASIC的架構優勢,開發者不再因為覺得TPU比較好寫相應程式、效率比較高而跳槽,因為現在NVIDIA GPU也能用同樣的邏輯運作。

策略二:降低門檻,鞏固Python/AI開發者生態

目前的AI開發主流語言是Python (及其函式庫 NumPy、PyTorch),而傳統CUDA開發則需要精通C++與底層硬體知識 (如記憶體管理、執行緒同步),因此門檻極高。

推出cuTile Python與CUDA Tile,則是NVIDIA向廣大Python開發者社群遞出的橄欖枝。透過更高階的抽象層,開發者可以像寫NumPy一樣直觀呼叫GPU算力。當「寫 CUDA」變得跟「寫Python」一樣簡單時,NVIDIA生態系的黏著度將進一步提升,讓AMD的ROCm或Intel的OneAPI更難切入。

競爭分析:對抗Google、AWS與AMD的全面封鎖

從市場競爭角度來看,CUDA Tile 是一步精妙的棋:

• 對抗Google TPU / AWS Trainium:雲端巨頭紛紛自研晶片,強調其架構專為AI打造。NVIDIA透過CUDA Tile告訴市場:「你不需要專用晶片,我的GPU只要換個寫法,就是最強的專用晶片」,如此即可有效降低企業為了追求特定架構效率,進而轉向採購非NVIDIA晶片的意願。

• 壓制AMD Instinct / ROCm:AMD目前正努力讓ROCm追趕上CUDA的發展腳步。不過,當AMD還在努力優化傳統SIMT模型的相容性時,NVIDIA已經將戰場升級到以Tile為基礎的編程,意味進一步將技術門檻拉高,迫使追趕者必須同時兼顧傳統模型與新的張量運算模型,加大了追趕難度。

• 解決硬體碎片化問題:隨著NVIDIA自身硬體迭代速度加快 (Hopper、Blackwell,以及接下來的Rubin),每一代Tensor Core的細節都不同。CUDA Tile作為中間層,則是扮演硬體與軟體間的解耦角色,代表企業現在寫的演算法,未來將能無痛轉移到新架構上,對於需要長期維護的大型模型來說,將是難以抗拒的誘因。

總結:硬體是護城河,軟體是鱷魚

總結來說,NVIDIA推出CUDA Tile不僅僅是技術更新,更是商業戰略的展現。如果說H100/B200等硬體是NVIDIA的護城河,那麼CUDA Tile就是護城河裡的鱷魚。它透過讓GPU模擬TPU的運作邏輯,既保留了通用的靈活性,又掠奪了專用晶片的高效特性,讓競爭對手在軟硬體整合的戰場上,面臨更巨大的生存壓力。