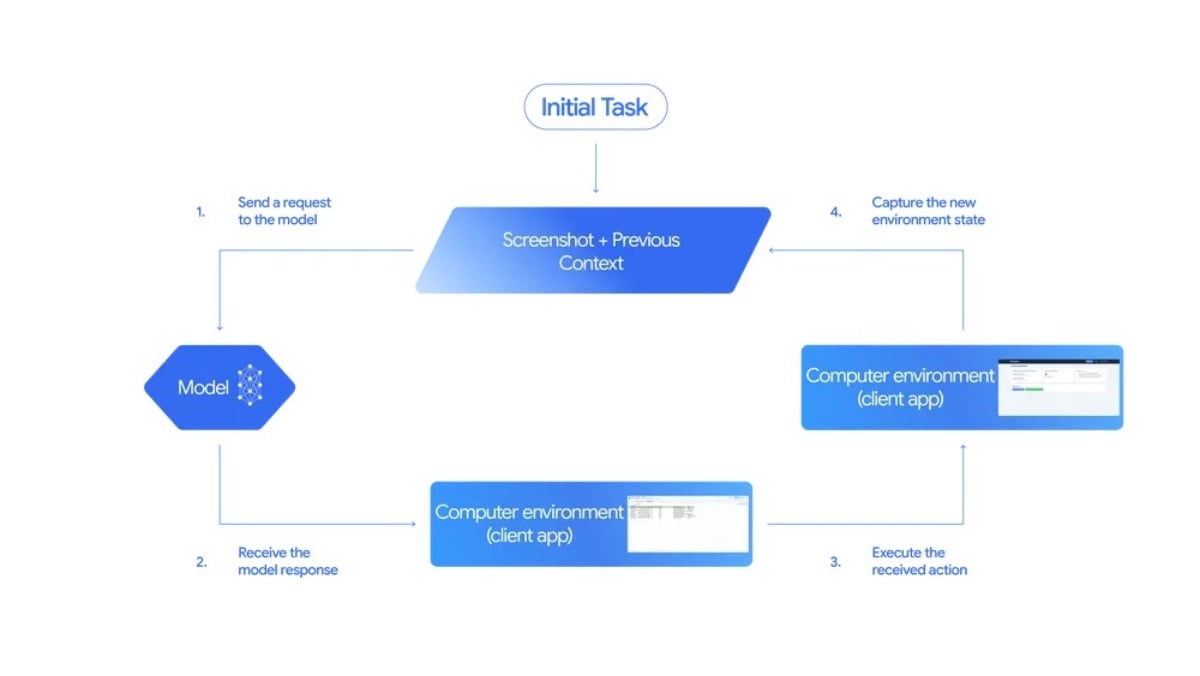

Google宣布預覽其最新一代AI模型「Gemini 2.5 Computer Use」,這款模型不只能理解文字或影像,還能像人一樣實際「操作」網頁介面。透過點擊、捲動、輸入與拖曳等動作,AI能在沒有API串連運作情況下完成任務,例如填寫表單、提交資料或在網頁上搜尋資訊,而這項技術讓AI不再只是回答問題,更能直接「行動」。

AI模擬人類操作介面,打開新應用場景

Google表示,Gemini 2.5 Computer Use模型具備「視覺理解與推理能力」,可觀察網頁內容後依據使用者指令完成實際操作。這讓AI無需依賴API串連,也能與網頁等操作介面進行互動,應用範圍則涵蓋UI測試、自動化操作、資料收集或企業內部工具整合等。

該模型目前支援13種操作指令,包括開啟網頁、輸入文字、點擊按鈕與拖放元素等。Google指出,這項功能尚未支援完整的桌面系統控制,但在多項網頁與行動端操作基準測試中表現優於同級產品。

延伸自Project Mariner,可自動完成瀏覽任務

Gemini 2.5 Computer Use其實是Google先前研究計畫「Project Mariner」的延伸,該專案曾展示AI能自主在瀏覽器中完成複雜任務,例如根據食材清單自動將商品加入購物車。

此次新版本已經整合進Gemini平台,並且同步支援開發者在Google AI Studio與Vertex AI上取用。

對抗OpenAI與Anthropic,AI「行動代理」競爭升溫

Google的新發表緊接在OpenAI於Dev Day活動上公布全新ChatGPT App與Agent功能之後,強調AI可自主完成多步驟任務。而Anthropic也早在去年推出支援電腦操作的Claude Computer Use模型。

不同於競爭對手允許AI控制整個電腦環境,Google強調Gemini目前僅限於瀏覽器層級操作,目的在於同時確保安全及可控性。即便如此,Google表示該模型在多項實測中依舊「超越其他主流替代方案」,並且將持續優化以支援更多互動與應用場景。

AI從「會說話」走向「會操作」

Gemini 2.5 Computer Use象徵著生成式AI從「語言理解」邁向「行動能力」的新階段,未來開發者不僅能透過指令讓AI回答問題,更能讓它直接執行操作任務。

在人類操作與自動化之間,Google顯然試圖打造一種新的AI互動模式——讓 AI 不只是助手,而是能真正「動手」的虛擬代理人。