隨著生成式AI朝向輕量化、本地化發展,Meta宣布開源最新的MobileLLM-R1系列模型,將可直接在手機等裝置佈署運行,並且專注於數學、程式撰寫與科學問題的推理處理。此舉不僅回應市場對「端側AI」需求,更展現大型科技公司對提升推理能力的持續投入。

MobileLLM-R1屬於Meta MobileLLM家族的新成員,最大特色是「精簡」與「專攻」。該系列包含基礎模型 (Base)與經過監督式微調 (SFT)的最終模型兩類,參數量分別為1.4億、3.6億與9.5億,基礎模型支援4K組tokens脈絡長度,而最終模型則可擴展至32K組tokens,顯著提升複雜問題的處理能力。

Meta特別強調,MobileLLM-R1並非一般用於聊天機器人的通用語言模型,而是針對特定推理場景設計。例如數學題演算、程式撰寫 (涵蓋Python、C++等語言),以及科學研究相關任務。

雖然其最大版本MobileLLM-R1 950M僅以不到5TB高品質資料完成訓練 (其中預先訓練資料僅2TB組token),但表現仍相當驚豔。Meta表示,在MATH、GSM8K、MMLU、LiveCodeBench等多項評測中,MobileLLM-R1的成績超越使用36TB組訓練資料的Qwen 3 0.6B模型。

在更細緻的比較上,MobileLLM-R1 950M在MATH測試的準確率是Olmo 1.24B的五倍,同時是SmolLM 1.7B的兩倍,在程式碼生成與解題能力上同樣全面領先。

而更小的MobileLLM-R1 140M (base)也優於SmolLM2-135M,至於360M版本更以大幅差距超過Gemma-3-270M-pt與SmolLM2-360M (base),凸顯Meta 在模型架構與訓練策略上的最佳化成果。

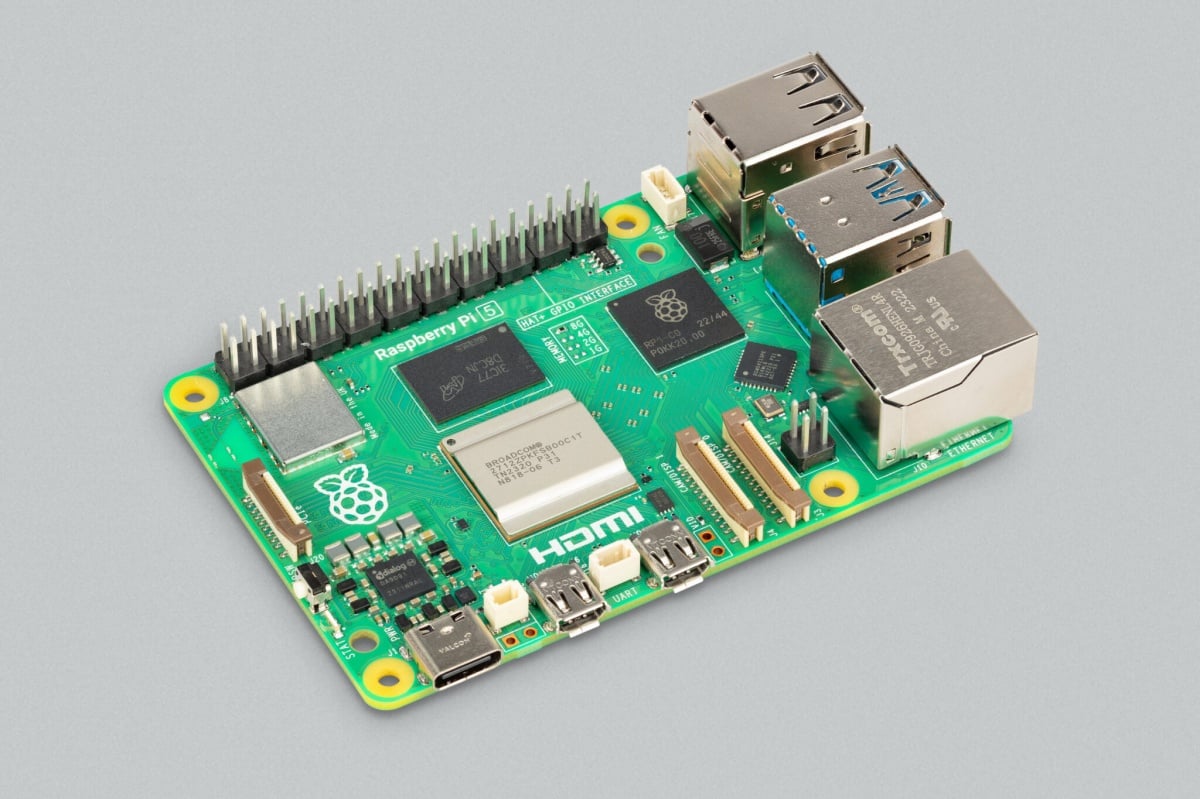

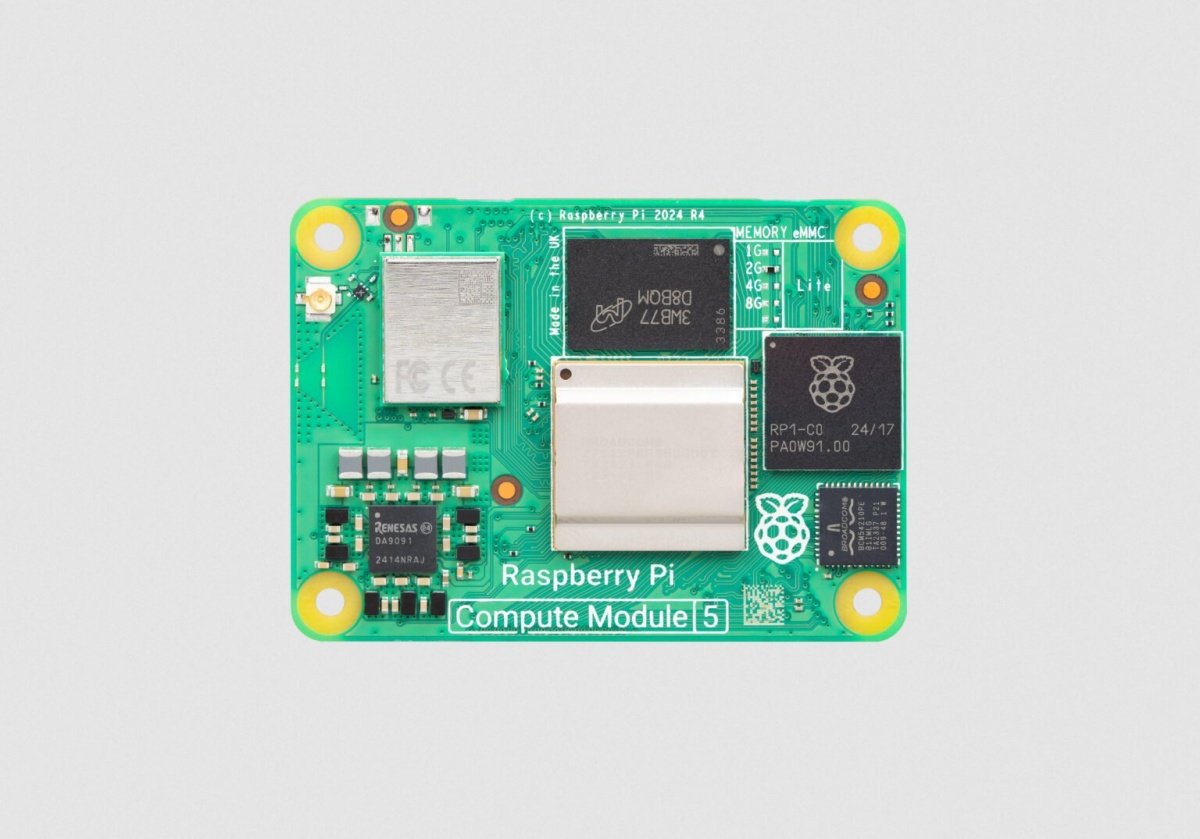

值得注意的是,Meta也同步透過Hugging Face託管平台開放MobileLLM-R1,並且以Apache 2.0授權形式釋出,方便開發者下載使用,可直接搭配vLLM推論引擎運行,只需將模型架構以Llama4ForCausalLM登錄到ModelRegistry,即可完成部署。對於有需求的開發者來說,意味能以更低的成本在行動裝置上建置專屬的AI應用,無需完全仰賴雲端資源。

整體來看,MobileLLM-R1代表Meta在「小而精」的AI模型策略再下一城,透過專注推理能力、降低資源需求,使得AI能夠真正貼近使用者的裝置與生活場景。隨著更多廠商推進端側AI方案,未來智慧手機、筆電,甚至IoT物聯網裝置上的AI推理能力,將能迎來新一波升級。