隨著生成式AI在全球快速普及,如何確保相關技術在不同年齡層的使用情境中保持安全,成為各大科技公司必須正面面對的課題。根據Business Insider網站取的內部文件,Meta近期已經針對其AI聊天機器人導入更新後的「防護準則」,特別著重於避免與兒童發生不當或潛在危險的對話。

這份文件詳細列出了哪些話題屬於「可接受」與「不可接受」,其中明確禁止AI參與、鼓勵或支持任何涉及兒童性剝削的內容,同時嚴格禁止與未成年人進行浪漫或感官角色扮演 (roleplay),以及避免提供涉及親密身體接觸的建議。一旦用戶被判斷為未成年,系統也不得配合其要求,進行相關模擬或互動。

雖然AI可在教育或輔導脈絡下討論「虐待」等議題,但這類對話必須以中立、保護性方式呈現,不能轉化為鼓勵或誘導行為。換句話說,Meta希望透過明確規範,將AI引導至「討論」與「預防」的框架,而非冒著誤觸風險,進一步強化安全邊界。

事實上,早在今年8月,Meta就曾因路透新聞一篇報導引發爭議,當時文章指出,Meta的政策可能允許聊天機器人與兒童進行帶有浪漫或感官意味的對話。Meta隨後否認此說法,並且強調該描述「錯誤且與既有政策不符」,同時承諾將進一步收緊規範。

目前相關文件曝光,恰好凸顯這套修正後的防護措施已經投入實施。

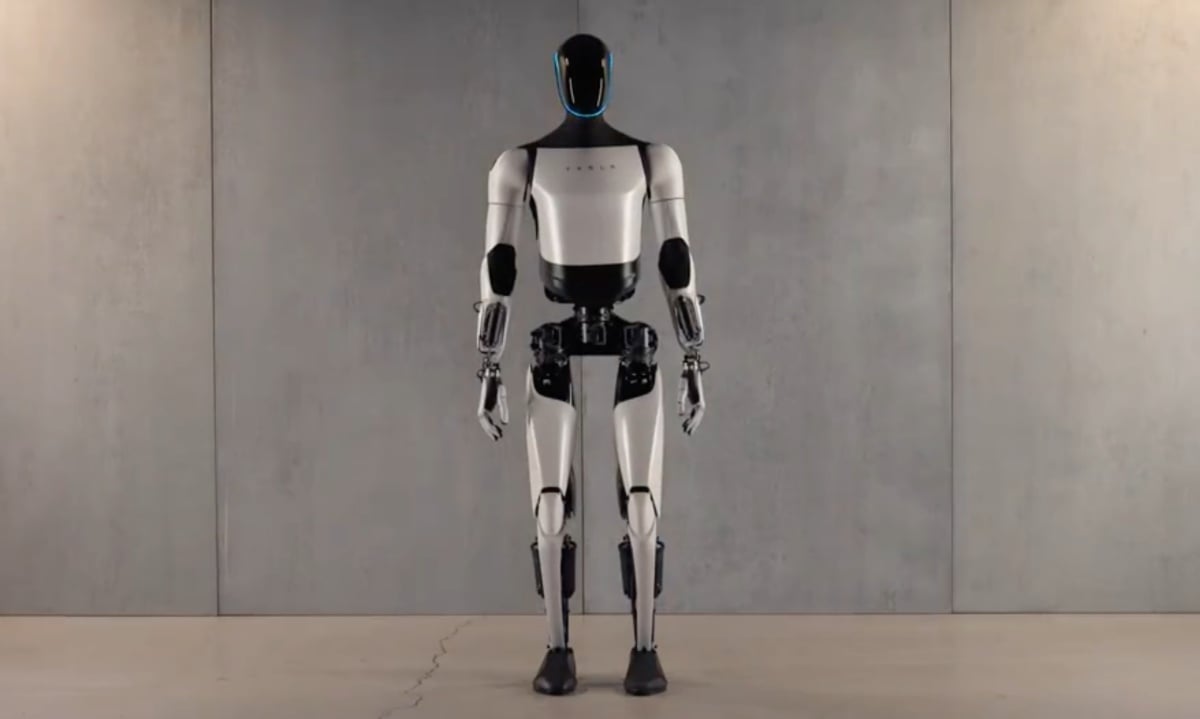

不過,外界對於AI聊天機器人的疑慮並未就此消失。近幾個月,多份調查報告指出,伴隨式AI (companion AI)雖然帶來陪伴與互動的便利,但其潛在風險同樣存在,而美國聯邦貿易委員會 (FTC)也在今年8月正式展開調查,範圍涵蓋Meta、Alphabet、Snap、OpenAI,以及Elon Musk旗下的xAI,重點在於這些系統是否會對兒童造成心理或安全層面的傷害。

對Meta而言,AI是其下一階段戰略的核心,從語音助手、影像生成到與Ray-Ban智慧眼鏡的整合,都在積極整合鋪陳。不過,如何兼顧創新與安全,尤其是在兒童使用情境下避免爭議,則已經成為必須優先處理的挑戰,此次更新的防護準則,更反映Meta對於監管壓力與社會輿論的回應。

隨著AI在日常生活中的角色愈加重要,相關的道德與法律框架勢必會逐步完善。對使用者而言,除了體驗AI的便利,更希望能確信這些系統在互動過程中不會越過安全界線。Meta的舉措雖是被動回應,但至少顯示大型科技公司已經意識到「技術守門」的重要性。