針對今年在GTC 2024期間揭曉的「Blackwell」顯示架構,並且說明將推出B100、B200與GB200 Superchip三種加速運算元件設計之後,NVIDIA稍早於Hot Chips 2024活動上進一步說明此加速運算元件細節。

「Blackwell」顯示架構針對兆級規模參數量的人工智慧需求打造

在先前說明裡,NVIDIA表示「Blackwell」顯示架構是針對兆級規模參數量的人工智慧需求打造,本身以台積電客製化4nm製程生產,並且能藉由單一GPU設計對應20 PetaFLOPS算力表現,結合此GPU設計的Superchip涵蓋2080億組電晶體,分別可在訓練效率相比先前推出的「Hopper」提升4倍,推論運算效率則可提高30倍,而能源使用效率更提升25倍。

架構方面,「Blackwell」整合第二代Transformer人工智慧引擎、可對應FP4/FP6低位元浮點運算的Tensor Core設計,並且對應第五代NVLink連接技術,最多可同時與576組GPU連動,支援每秒達800GB的資料解壓速率,以及更安全資料加密保護機制,更可確保運作穩定性。

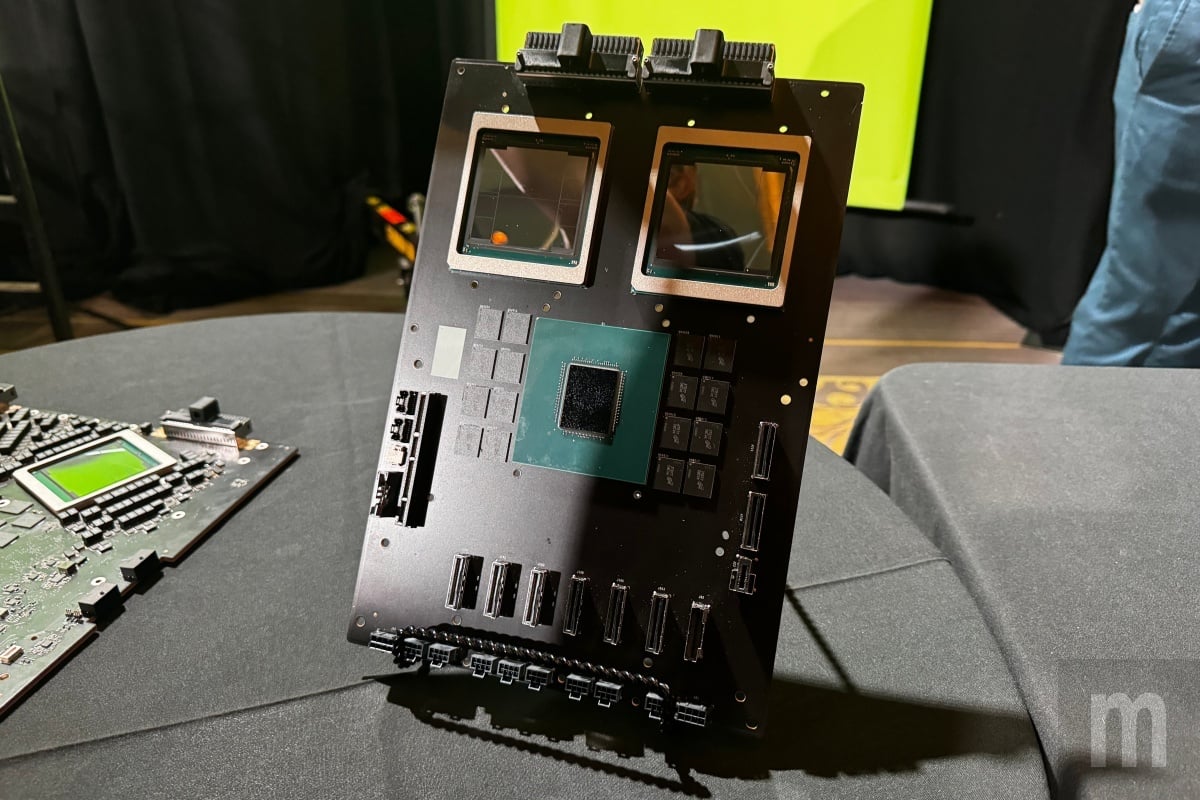

另外,「Blackwell」也以兩組光罩對應Die裸晶核心單元構成的特殊設計,內部則以每秒10TB資料傳輸速率方式的NVLink-HBI介面進行溝通,並且能以單一GPU形式運作,而在與「Grace」CPU溝通部分則是以NVLink-C2C介面連接。

支援降低計算精度換取更高人工智慧執行效率

運算部分,「Blackwell」可對應近期市場提出的FP4、FP6精度計算,藉由降低精度計算換取更大人工智慧執行效能,並且減少單次運算所需花費時間與電力,但也強調在特定FP4精度計算情況下,效能可貼近BF16。

而在目前諸多人工智慧運算更著重判斷、推論執行效率情況來看,NVIDIA在「Blackwell」設計作此調整,主要就是為了因應更快的人工智慧執行反應表現使用需求,畢竟並非所有人工智慧應用功能都需要透過高精度計算完成。

更高組合彈性

目前以「Blackwell」顯示架構打造加速運算元件設計,分別區分B100、B200,以及結合單組「Grace」CPU與兩組「Blackwell」GPU構成的GB200 Superchip。

其中,B100、B200均搭載總容量達192GB的HBM3e高密度記憶體,對應每秒8TB資料傳輸量,同時與 GPU本身對應資料傳輸量相同,因此在顯示架構上可以對應更快資料處理效率。

至於B100、B200兩者最大差異在於運作功耗不同,前者最高功耗為700W,可藉由空冷散熱形式運作,同時也能直接用在H100加速元件設計對應HGX機架空間內,後者功耗則在一般情況下對應1000W,依然可透過空冷形式運作,但能否用於H200既有對應機架空間則要看情況,至於若將功耗進一步提高至1200W,就必須以水冷形式運作,因此對應機架就必須重新設計。

若以H100算力為基礎,GB200 Superchip的算力為6倍,約可處理GPT-3 1750億組參數量,而對應處理多模特定領域算力表現則可達30倍,可處理多達1.8兆參數規模。

透過NVLink將36組GB200 Superchip串接成的GB200 NVL72,可在訓練對應720 PFLOPS算力表現,推論算力則可達1440 PFLOPS,同時可對應27兆組參數規模,多節點傳輸頻寬可達每秒130TB,最高可對應每秒260TB傳輸量。

另外,將8組GB200 NVL72串接的話,則可建構DGX BG200 Superpod,整合288組「Grace」CPU與576組「Blackwell」 GPU構成,並且包含240TB高速記憶體容量,在FP4運算模式可對應11.5 ExaFLOPS算力表現,並且發揮30倍推論效率、4倍訓練效率,同時提升25倍能源使用效率。

在組合方面,NVIDIA依然在「Blackwell」顯示架構維持組合彈性,可選擇與x86架構CPU或Arm架構CPU組合,而在B100設計上也能相容既有H100對應機架使用,B200在特定情況下也能相容使用既有機架,藉此維持其佈署應用升級彈性,同時也在運算效能有相當程度提升表現。

但如果是要對應 人工智慧佈署應用的話,NVIDIA表示當前最佳組合還是Arm架構CPU,主要還是受限於x86架構CPU對應I/O埠等通道設計,以及NVLink可對應連接數量上限,加上採用x86架構CPU還有額外散熱系統建置需求,因此目前用於人工智慧推論等訓練,依然會主推搭配「Grace」CPU的組合。

未來發展

在今年Compoutex 2024展前主題演講上,NVIDIA說明將以一年節奏 (One Year Rhythm)持續推動技術成長的發展目標,更預告接下來將以Blackwell架構GPU為基礎,於2025年接續推出名為「Blackwell Ultra」的GPU,另外也確認下一代顯示架構代號為「Rubin」,同時也確定會推出名為「Rubin Ultra」的GPU產品,預計會在2026年推出。

除了將持續推出新款GPU產品,NVIDIA也確認將推出代號「Vera」的CPU產品,以及第六代NVLink設計與Spectrum-X1600乙太網路平台,藉此加速更大規模人工智慧應用發展。