NVIDIA宣布,正式開源旗下Audio2Face模型與相關SDK,讓遊戲與3D應用開發者能更輕鬆導入這項先進技術,打造擬真角色動畫與更具臨場感的互動體驗。除了模型與軟體開發工具包,NVIDIA也將提供完整的開源訓練框架,開發者可依照不同應用需求進行微調或客製化,實現高度彈性的使用方式。

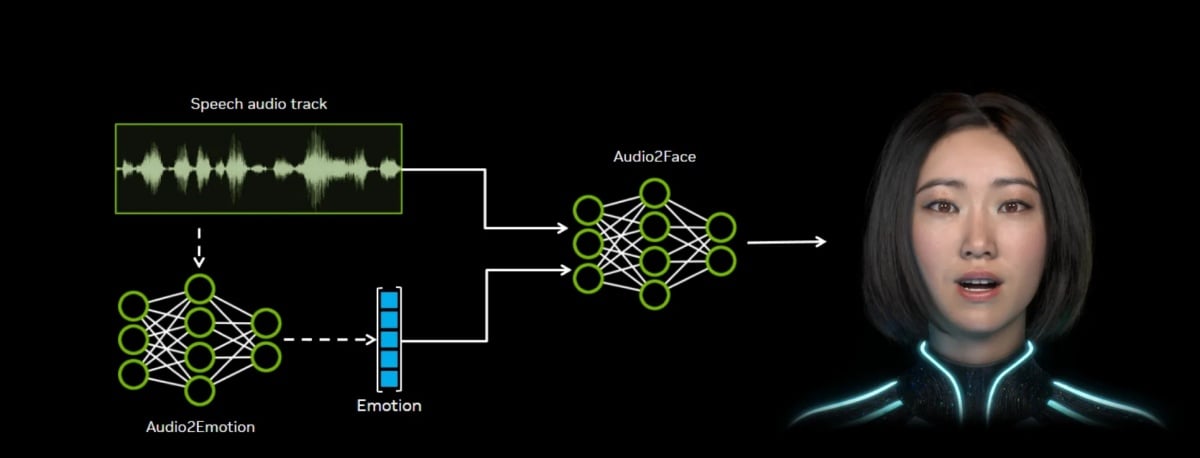

隸屬今年初在CES 2025對外展示的Project R2X項目一部分,Audio2Face技術最大亮點在於能以生成式AI自動將語音轉換為栩栩如生的臉部表情與嘴型動作。

無論是遊戲角色對話、客服機器人,甚至是虛擬主播的即時互動,都能透過這套技術展現自然且精準的嘴型同步與情感表達。開發者無需耗費大量時間進行逐格動畫設計,就能快速生成動態臉部動畫,顯著降低人力成本並縮短製作週期。

技術層面上,Audio2Face不僅能精準對應語音中的音位與語調,還能將生成結果以動畫數據串流的形式輸出,進一步用於離線渲染或即時串流。意味此技術既能支援高品質的預先內容製作,也能應用於需要即時反應的互動場景,例如遊戲NPC對話或即時虛擬人直播。

目前,Audio2Face已經被廣泛應用於遊戲與娛樂產業,包含Codemasters、GSC Game World、網易、完美世界等國際遊戲廠商,都已經在自家作品中導入相關技術。而獨立軟體供應商如Convai、Inworld AI、Reallusion、Streamlabs及UneeQ等,目前也透過Audio2Face打造更具沉浸感的虛擬互動解決方案。

NVIDIA表示,透過開源化,將進一步擴大Audio2Face技術應用生態圈,讓更多開發者能在NVIDIA ACE for Games平台上,找到完整的工具資源與應用案例,甚至能將其與其他生成式AI工具結合,打造更全面的數位化身解決方案。

過去,角色臉部動畫往往仰賴專業動畫師反覆調整,不僅耗時費力,也難以滿足即時應用的需求。而隨著Audio2Face的開源化,更多獨立團隊與新創公司將能以低門檻導入此技術,創造出風格獨特卻依然自然流暢的數位角色。對遊戲產業而言,更將有助於NPC角色的互動性大幅提升,而對媒體娛樂與虛擬客服來說,則能提供更擬真的對話體驗,縮短虛擬與現實的距離。

隨著生成式AI在各行各業快速普及,NVIDIA此次開源Audio2Face技術,不僅只是單純釋出工具資源,更進一步推動「數位人」技術走向標準化與普及化。未來無論是遊戲、影視製作,甚至是企業應用,都可能因這套技術而出現更多創新的互動型態。