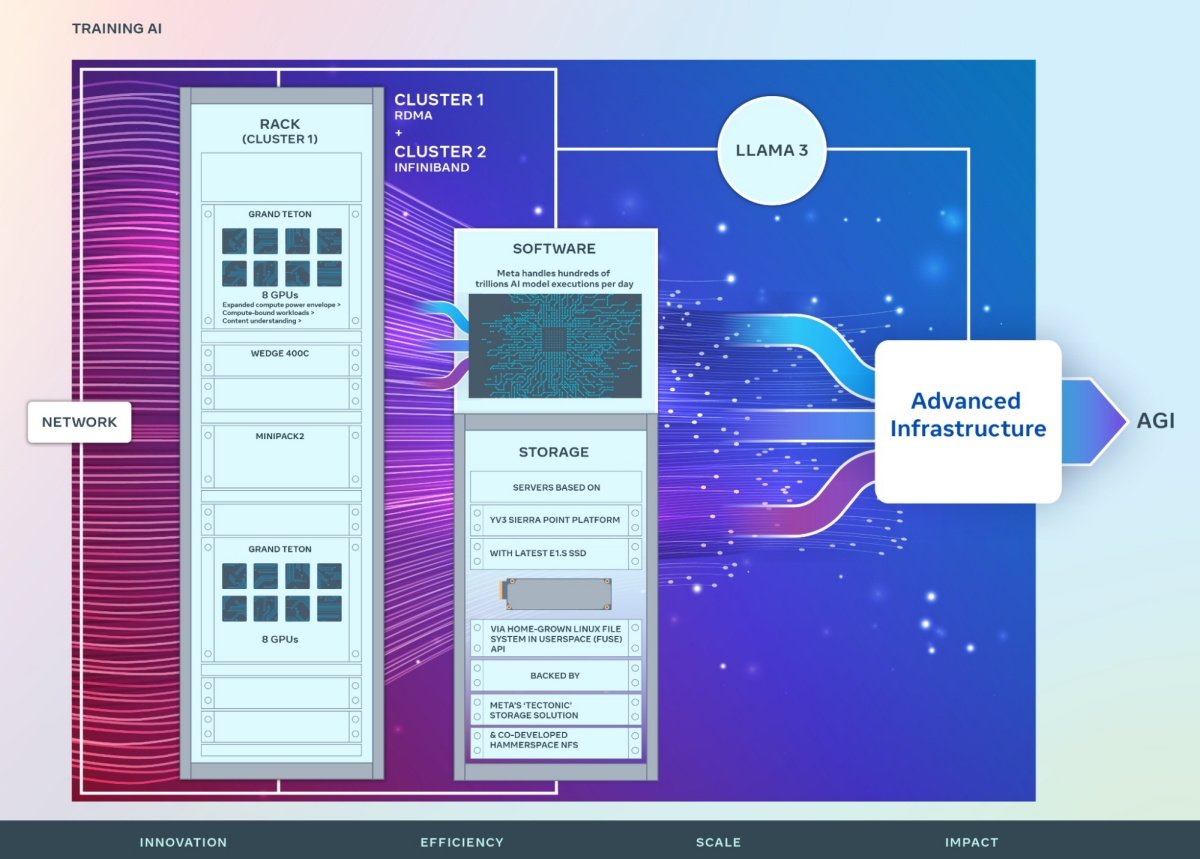

Elon Musk透露其人工智慧公司xAI已經以10萬組NVIDIA H100加速元件建構超級電腦,並且在近期正式上線,預計在未來幾個月內讓規格規模再擴大一倍。 目前xAI已經獲得包含Valor Equity Partners、Vy Capital、Andreessen Horowitz (A16Z)、紅杉資本、Fidelity、Prince Alwaleed Bin Talal及Kingdom Holding等機構投資,預計以獲得60億美元擴建其人工智慧基礎建設。 而xAI將此超級電腦命名為「Colossus」 (註),鍵置時間約花費122天,並且標榜為全球最強大的人工智慧訓練系統,後續計畫從現行的10萬組NVIDIA H100加速元件,增加為20萬組,其中更包含5萬組H200加速元件。 註:應該是指漫威中可將自身變成金屬狀態的超級英雄「鋼人」。 除了xAI藉由堆疊GPU為主的加速運算元件推動人工智慧技術發展,目前包含Google、OpenAI、Meta、微軟在內業者也均以相同作法進行人工智慧軍備競爭,包含Intel、AMD與NVIDIA都因此獲利,但由於許多人工智慧訓練更仰賴GPU加速,藉此縮短原本所需冗長的訓練時間,因此更讓GPU加速效能更高的NVIDIA獲利。 即便NVIDIA日前傳出其代號「Blackwell」的加速元件延後至年底出貨,甚至可能因為設計問題影響實際交貨時間,但仍吸引不少業者下訂。 This weekend, the @xAI team brought our Colossus 100k H100 training ...