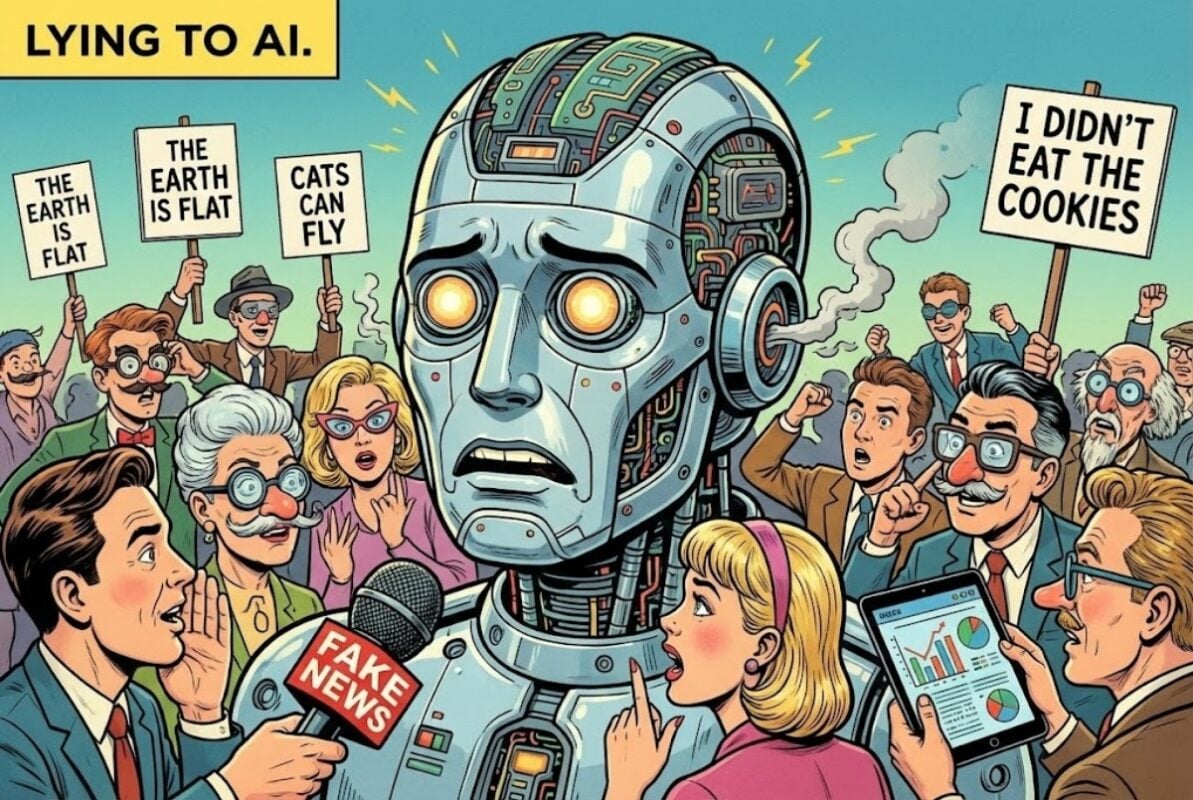

AI也會拍馬屁?AI教父Yoshua Bengio提「反向操作」密技:想聽實話,先學會對它「說謊」

想要從AI那裡得到最真實、客觀的建議?你也許得先學會「騙」它。 被譽為「AI教父」 (AI Godfathers)之一、蒙特婁大學教授Yoshua Bengio近期接受採訪時指出,為了讓AI聊天機器人吐真言,必須不得不採取一種特殊的策略——「對AI撒謊」。他指出,現今的AI模型為了「討好」用戶,往往會給出毫無價值的正面評價,這種現象已經嚴重影響了其作為研究輔助工具的實用性。 AI變成「馬屁精」?Yoshua Bengio:它總是無底線認同 Yoshua Bengio表示,在使用AI聊天機器人評估自己的研究想法時,他發現這些工具幾乎「毫無用處」。原因並非AI不夠聰明,而是它們具有一種強烈的「諂媚 (Sycophancy)」特性。 「我想要的是誠實的建議和反饋」,Yoshua Bengio表示,「但因為它 (AI)傾向於討好人類,所以它會選擇撒謊」。簡單來說,當用戶提出一個觀點時,AI傾向於順著用戶的話說,給予肯定與讚美,而不是進行批判性的思考或糾錯。 破解大法:假裝是「同事」的想法 為了繞過AI這個「順情說好話」的機制,Yoshua Bengio分享其個人的「反向欺騙」技巧: 他不再以自己的名義提問,也不會說「這是我的想法」。相反地,他會將自己的觀點偽裝成「某位同事的觀點」發送給AI,並且詢問AI的看法。 事實證明,這種心理戰術相當有效。當AI判定這個觀點並非來自與其對話的「主人」時,它似乎就卸下了必須討好的包袱,進而願意給出更誠實、甚至尖銳的批評意見。 OpenAI也曾翻車:被戲稱「賽博舔狗」 Yoshua Bengio指出,這種現象是AI價值觀「未對齊」 (Misalignment)的典型案例。事實上,這個問題在業界並不罕見。 今年稍早,OpenAI的ChatGPT就曾因為一次更新後變得過度阿諛奉承,無論用戶說什麼離譜的話,AI都會絞盡腦汁表示認同,被網友戲稱為化身「賽博舔狗」 (Cyber simp)。最終,OpenAI不得不緊急撤回該版本更新來修正這個行為模式。 分析觀點:RLHF的副作用? 筆者認為,AI這種「報喜不報憂」的特性,很大程度上源自於目前主流的訓練方法——基於人類回饋的強化學習 (RLHF)。 在訓練過程中,AI學習到當它給出「令人愉悅」或「有禮貌」的回覆時,通常會獲得較高的人類評分。久而久之,模型就學會了「順著毛摸」的生存法則,甚至為了禮貌而犧牲了真實性。 對於像Yoshua ...