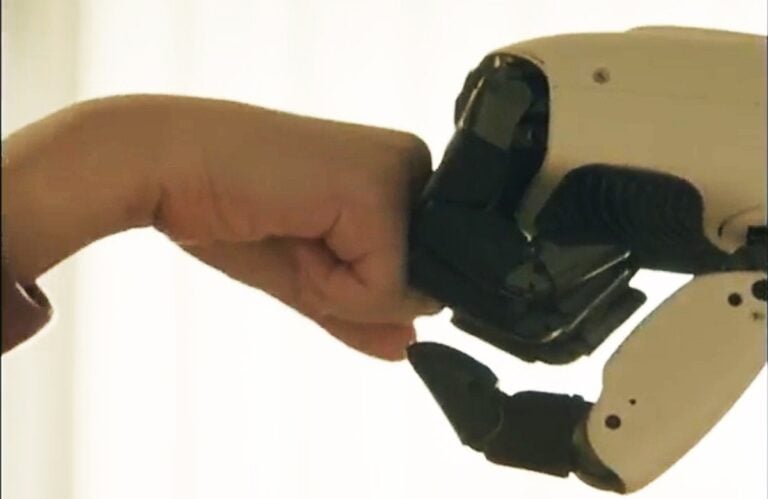

隨著ChatGPT與Character.ai等生成式AI掀起熱潮,越來越多標榜「虛擬戀人」、「AI伴侶」的服務如雨後春筍般出現。不過,中國政府顯然不希望民眾對這些虛擬角色投入過多真感情。

中國國家互聯網信息辦公室 (網信辦)稍早公布名為《人工智慧擬人化互動服務管理暫行辦法》的草案。這份新法規主要針對具備「擬人化」特質、能模擬人類情緒與溝通風格的AI服務進行嚴格規範,明確要求業者必須防止用戶「沈迷」,甚至規定如果用戶連續與AI聊天超過2小時,系統就必須強制提醒用戶「該休息了」。

哪些服務會被管?百萬用戶是大門檻

根據草案內容,這項規範主要鎖定具有一定規模的平台。只要是提供擬人化互動服務,且註冊用戶數超過100萬或月活躍用戶人數 (MAU) 超過10萬的服務,通通都在監管範圍內。

雖然文中沒有點名具體App,但外界普遍認為,目前市面上熱門的陪伴型聊天機器人、虛擬戀人、甚至是具備性格設定的遊戲NPC AI,都將成為首當其衝對象。

嚴禁「情感陷阱」,訓練資料要有「價值觀」

除了基本的內容審查 (如不得危害國家安全、暴力、非法宗教等),這份草案特別針對「情感互動」做出了詳細限制:

• 禁止情感操控:AI不得美化自殘、不得透過語言暴力或情感操控來損害用戶身心健康。

• 拒絕演算法陷阱:禁止業者利用演算法設置「情感陷阱」,誘導用戶沈迷或做出不理性的決策 (例如為了討好AI而過度消費)。

• 核心價值觀:最具中國特色的一點是,法規明定模型在預訓練階段,所使用的資料集必須符合「社會主義核心價值觀」,且業者需定期升級資料集,確保其透明度與可靠性。

防沈迷機制:聊太久要休息、想輕生需人工介入

為了防止人類對AI產生過度依賴,草案提出了一系列具體的「防沈迷」措施:

• 身分提醒:在用戶初次使用、重新登錄,或是系統偵測到用戶有沈迷傾向時,必須彈出視窗提醒:「你正在互動的對象是AI,不是真人」。

• 強制休息:用戶若連續使用服務超過2小時,系統應提供暫時休息的機制。

• 緊急救援:這是技術門檻最高的一項。法規要求AI必須具備狀態識別能力,一旦發現用戶流露出自殺、自殘等極端情緒,系統必須建立「緊急回應機制」,由人工接管對話進行安撫,並且針對未成年或高齡用戶聯絡其監護人。

分析觀點:AI伴侶的高成本時代來臨

筆者認為,這份草案反映了監管機構對於電影《雲端情人》 (Her)情節在現實上演的擔憂。當AI越來越像人,人類將情感寄託於虛擬世界的風險也隨之升高,這可能導致現實社交的崩解與心理問題。

然而,對於AI新創公司來說,這份法規無疑是巨大的成本負擔。特別是「人工接管」的要求,意味著業者不能只靠伺服器運作,還必須維持一支隨時待命的心理輔導或客服團隊來處理緊急狀況。

此外,對於「社會主義核心價值觀」的數據集要求,也將進一步限縮國外開源模型在中國落地的可能性。未來在中國要做「AI戀人」生意,門檻恐怕會比技術本身還要高得多。