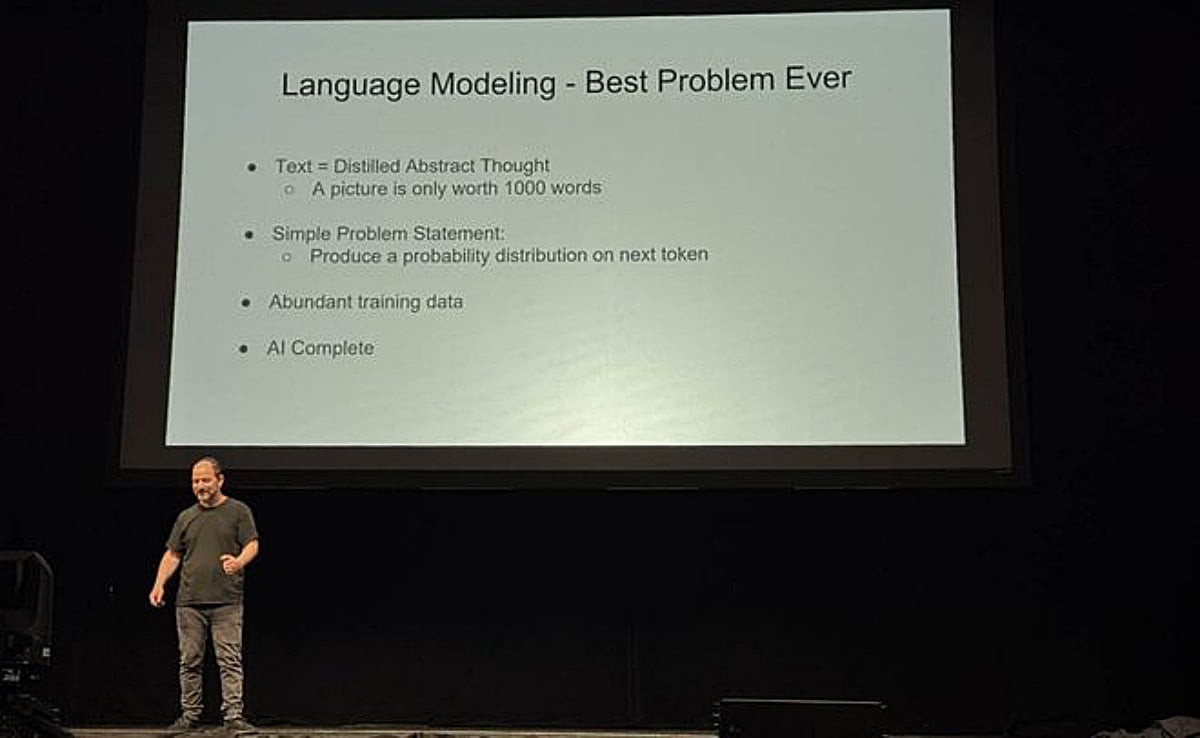

在近期舉辦的Hot Chips 2025大會上,Google DeepMind Gemini專案共同負責人,同時也是Transformer模型論文《Attention Is All You Need》共同作者之一的Noam Shazeer,以《下一階段AI的預測》為主題,說明AI的下一個階段發展。

Noam Shazeer過去曾因Google拒絕承認聊天機器人有「自己意識」,進而離職創辦人工智慧技術公司Character.AI,隨後再以27億美元天價「回歸」Google體系,成為Google DeepMind科學家。

「LLM想要什麼?」—算力、記憶體、網路頻寬

在Hot Chips 2025大會演講中,Noam Shazeer指出大行語言模型最需要的就是算力。更多的FLOPS,意味著更大的模型、更長的上下文、更好的推理能力。

Noam Shazeer更回顧2015年時在32組GPU上訓練模型被視為大事,但十年後,可能需要動用數十萬顆GPU才能支撐最新LLM訓練規模。

在Noam Shazeer看法中,算力必須達到Petaflops級別,甚至更高,才能滿足大模型的訓練需求。而更大記憶體與更高頻寬則決定能塞下多大的AI模型,以及推理時能保存多少中間狀態,對長上下文、注意力機制極為重要。

另外,網路頻寬也在模型參數分散在整個運算網路時扮演重要關鍵,必須確保跨晶片資料交換的延遲極低,才能加快推理速度,支持「長思維鏈」推理。

Noam Shazeer進一步指出,除了提升硬體規模,降低計算精度 (如 FP8、INT4)以換取更高效能是合理的,但不可犧牲可重現性 (determinism),否則無法有效調試和驗證模型。

軟硬體協同,推動AI向前

Noam Shazeer被稱為「反向跨界者」,對TPU的底層網路架構充滿好奇,並且推動Mesh-TensorFlow等專案。Noam Shazeer認為,軟硬體協同設計是LLM成長的關鍵,從片上SRAM、高頻寬記憶體,到叢集網路設計,都要配合模型需求調整,藉此挖掘最大潛能。

同時,Noam Shazeer以一句話作為總結:「擁有更大、更快、更穩定的叢集,就能訓練出更聰明的模型。」

如果硬體不再進步,還能實現AGI嗎?

而當現場觀眾拋出尖銳問題:「如果今天起硬體停止進步,我們還能實現AGI嗎?」,Noam Shazeer罕見地給出肯定答案:可以。

Noam Shazeer認為,AI本身會加速軟體與系統設計的演化,即便硬體停滯,依舊能透過演算法創新持續突破。不過,Noam Shazeer也補充:「如果能拿到更好的硬體,當然更好。」