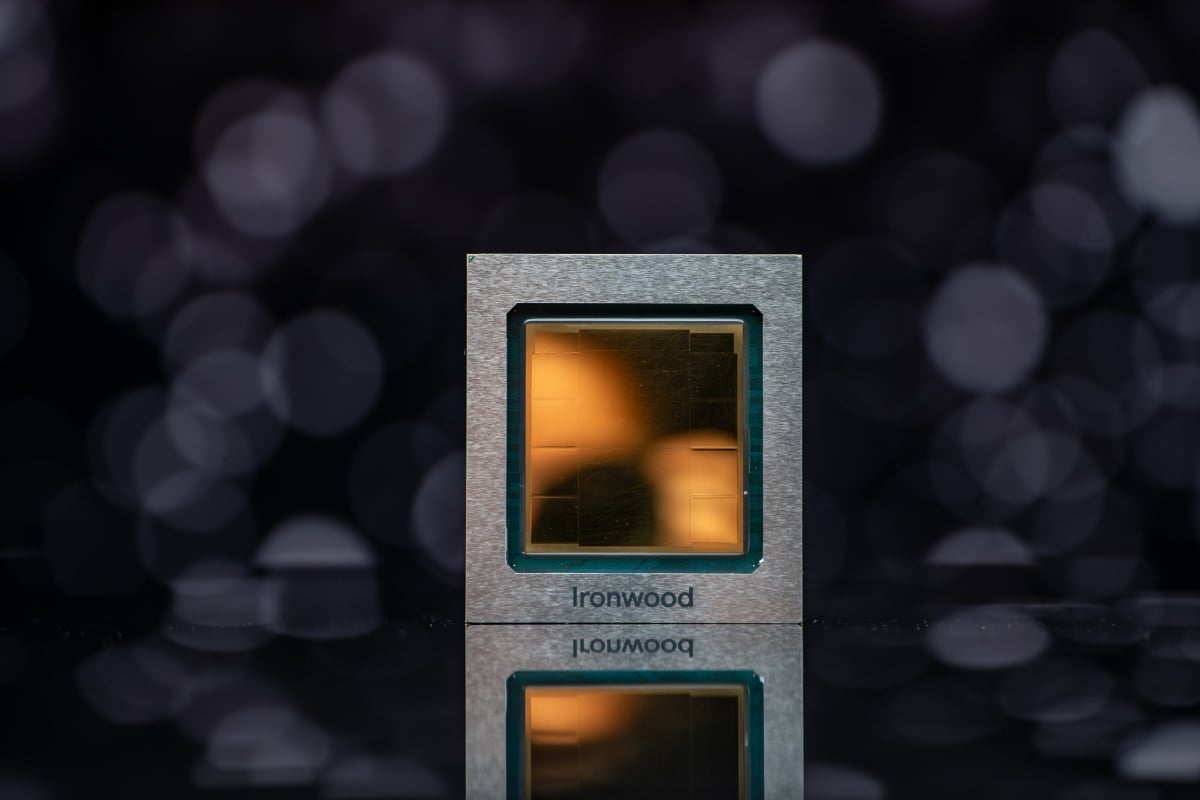

在今年Next’25大會活動上公布代號「Ironwood」、標榜性能最高,同時更針對人工智慧「思考」加速打造的第7代TPU之後,Google Cloud宣布此款TPU將在未來幾週內正式投入使用,並且對應大規模模型訓練與高容量、低延遲的AI推論運作,同時也呼應代理式AI (Agentic AI)工作流程帶動的龐大運算需求。

Google指出,Ironwood相比前代TPU (代號「Trillium」的第6代TPU),在訓練與推論工作負載上均提供了超過4倍的效能提升,是其迄今最強大、最具能源效率的客製化晶片,更可針對人工智慧模型進行「思考」、主動提供見解時進行加速,藉此讓更多人工智慧代理服務能更快執行運作。

而Google Cloud也確認近期與AI合作夥伴Anthropic簽署價值數百億美元的多年期協議,其中便包含此次宣布正式投入應用的「Ironwood」,同時提供使用TPU將多達100萬組,藉此支援其Claude系列模型的訓練與服務運作。

瞄準推論時代:Ironwood導入9.6Tb/s晶片互連速率與1.77PB共享HBM

在先前說明中,Google已經說明「Ironwood」是以9216組液冷晶片組成,並且透過晶片間互連網路介面 (ICI)串接,可對應42.5 Exaflops算力表現,約為目前全球最大規模超級電腦El Capitan對應算力的24倍,同時也能對應最大規模的人工智慧工作負載平行處理能力,而每組晶片的峰值算力均可達4614 TFLOPS。

Google強調,TPU是其「AI Hypercomputer」整合式超級運算系統的關鍵核心。新推出的「Ironwood」更是具備驚人的擴展能力與系統級效能,並且能藉由傳輸速率高達9.6Tb/s的晶片間互連網路介面,消除傳統配置下的資料瓶頸,讓數千顆晶片協同運作如單一大腦。

• 巨量共享記憶體:

此次擴展能力,使其能共同存取高達1.77 Petabytes (PB) 的共享HBM (高頻寬記憶體)。Google解釋,這如同為AI 超級大腦提供了破紀錄的「共享工作區」,能將最龐大的AI模型完整載入,大幅提升運算效率,並且降低總持有成本 (TCO)。

• 高可靠性 (OCS):

導入光學電路交換 (Optical Circuit Switching, OCS) 技術,作為動態光纖網路 (dynamic fabric),能在偵測到中斷時立即繞路,確保關鍵AI服務不中斷,提供最高規格的營運韌性。

在Google提供的補充資料中,更提到Ironwood Pod能提供比「下一個競爭對手」高出118倍的FP8 ExaFLOPS算力,顯示其在AI專用運算上的強大效能。

Anthropic百萬組TPU大單,鞏固Google AI基礎設施地位

目前Anthropic承諾向Google Cloud採購使用多達100萬組TPU,無疑是對Google AI基礎設施的重大背書。

Google指出,包含自家的Gemini、Veo、Imagen,以及Anthropic的Claude等模型,都是在TPU上進行訓練與服務。

而此合作也呼應了Google Cloud上週公布財報,其中便強調AI基礎設施 (尤其是TPU) 的空前需求,是其主要增長動力之一。

同步更新Axion CPU,N4A 實例進入預覽

在發表專用AI加速器的同時,Google 也強調代理AI (Agentic AI) 工作流程需要通用CPU與AI加速器之間的緊密協同運作。為此,Google也同步更新了其Arm架構設計CPU產品線:

• N4A實例 (導入Axion CPU設計):

基於Google第四代N系列VM (虛擬機器)的全新Axion CPU應用實例N4A,目前已經進入預覽 (Preview) 階段。

• 效能:

N4A號稱可提供相較目前同等級x86架構為基礎的VM高出2倍性價比,以及80%的每瓦效能輸出提升。

• C4A metal (裸機):

首款Axion處理器的裸機 (bare-metal) 應用實例C4A metal也即將進入預覽。

「系統級共同設計」的長期策略

Google強調,其AI基礎設施的成功,來自於「系統級共同設計」的長期策略——即模型研究、軟體與硬體開發都在相同屋簷下進行。從十年前打造首款 TPU、八年前催生Transformer架構,到如今在GigaWatt規模佈署具備99.999%妥善率的先進液冷系統,都是延續此策略的展現。